1. Contexte Dans l’écosystème actuel de la donnée, les entreprises doivent gérer des volumes...

Comprendre le fonctionnement des LLMs

Introduction

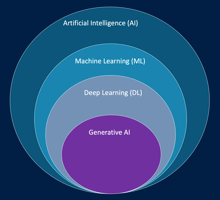

Les grands modèles de langage, ou LLMs (Large Language Models), comme GPT, Claude ou Amazon Titan Text, sont au cœur des avancées récentes en intelligence artificielle. Leur objectif est de comprendre, générer et manipuler du texte de manière naturelle à partir d’entrées en langage humain. Pour y parvenir, ils s’appuient sur un enchaînement d’étapes fondamentales : la tokenization, la représentation en embeddings, la prédiction du token suivant, et la gestion du contexte.

1. La tokenization : transformer le texte en unités compréhensibles par le modèle

Un LLM ne traite pas directement les mots tels que nous les écrivons. Avant tout calcul, le texte est découpé en unités plus petites appelées tokens. Un token peut correspondre à un mot entier, une partie de mot, un signe de ponctuation ou même un espace, selon la langue et le modèle utilisé.

Cette étape permet de convertir une phrase en une séquence numérique que le modèle peut analyser. Par exemple, la phrase “Les nuages sont blancs” pourrait être décomposée en tokens tels que “Les”, “ nu”, “ages”, “ sont”, “ blancs”.

Le choix du découpage influence directement la compréhension du modèle : plus le découpage est précis et cohérent, meilleure sera sa capacité à reconnaître les relations entre les éléments du texte.

2. Les embeddings : représenter les tokens dans un espace vectoriel

Une fois le texte découpé, chaque token est transformé en un vecteur numérique à l’aide d’une technique appelée embedding. Ce vecteur représente la signification du token dans un espace multidimensionnel.

L’idée centrale est que les tokens ayant des sens proches sont représentés par des vecteurs proches les uns des autres. Par exemple, les mots “chat” et “chien” auront des embeddings similaires, car ils appartiennent à des contextes linguistiques proches.

Ces représentations vectorielles permettent au modèle de “comprendre” les relations sémantiques et syntaxiques entre les mots, même s’il ne raisonne pas comme un humain. C’est cette étape qui donne au LLM sa capacité à saisir la nuance, la synonymie et le contexte d’un texte.

3. La prédiction du token suivant : le cœur du raisonnement du modèle

Le fonctionnement d’un LLM repose sur une idée simple mais puissante : prédire le prochain token dans une séquence à partir des précédents. À chaque étape, le modèle analyse les tokens déjà produits et estime, à l’aide de probabilités, quel est le token le plus probable pour continuer le texte.

Par exemple, si le modèle reçoit “Le ciel est…”, il attribuera une forte probabilité au mot “bleu”, une probabilité plus faible à “gris” et une très faible probabilité à “vert”.

Cette prédiction repose sur des milliards de paramètres ajustés lors de la phase d’entraînement, où le modèle a observé d’immenses quantités de textes. Ces paramètres capturent les relations entre les mots, la grammaire, le style et la structure du langage.

Le modèle génère ainsi du texte en choisissant, à chaque étape, le token suivant en fonction du contexte global et des probabilités calculées.

4. La fenêtre de contexte : la mémoire à court terme du modèle

Les LLMs ne “comprennent” pas un texte entier comme un humain. Ils se basent sur une fenêtre de contexte — une limite définissant le nombre maximum de tokens qu’ils peuvent prendre en compte simultanément.

Cela signifie qu’au-delà de cette limite, les premières parties du texte ne sont plus directement accessibles au modèle. Ce phénomène a un impact sur la cohérence des réponses longues ou sur des tâches nécessitant une mémoire étendue. Les modèles les plus récents, comme GPT-4-Turbo ou Claude 3, ont considérablement augmenté cette capacité, atteignant parfois plusieurs centaines de milliers de tokens.

La taille du contexte influence donc la capacité du modèle à gérer des conversations longues, des documents complexes ou des chaînes de raisonnement étendues.

5. Le lien entre tokens, coût et performance

Chaque token traité — qu’il soit en entrée (prompt) ou en sortie (réponse) — représente un coût de calcul. Dans la plupart des services cloud, comme Amazon Bedrock ou OpenAI, la facturation est directement liée au nombre de tokens utilisés.

Ainsi, un prompt plus long ou une réponse plus détaillée consommera davantage de tokens, augmentant le coût et le temps d’inférence.

Sur le plan des performances, le nombre de tokens influe également sur la précision : plus le contexte fourni est riche et bien structuré, plus le modèle peut produire une réponse pertinente. Cependant, une entrée trop longue ou non ciblée peut diluer les informations essentielles et dégrader la qualité de la prédiction.

L’efficacité réside donc dans un équilibre : fournir suffisamment de contexte pour guider le modèle, sans le surcharger inutilement.

Conclusion

Les LLMs fonctionnent grâce à une chaîne d’étapes qui traduisent le langage humain en représentations mathématiques exploitables par l’IA. La tokenization fragmente le texte, les embeddings en capturent le sens, la prédiction du token suivant permet de générer du texte, et la fenêtre de contexte fixe les limites de la mémoire du modèle.

Comprendre ces mécanismes est essentiel pour interagir efficacement avec un modèle, rédiger de meilleurs prompts et interpréter ses comportements. De plus, savoir que chaque token a un impact sur la qualité, la vitesse et le coût permet d’utiliser ces systèmes de manière à la fois stratégique et responsable.

--

Ce billet de blog fait partie du cours AWS AI Practitioner en français disponible sur Udemy et sur la plateforme LeCloudFacile.com.