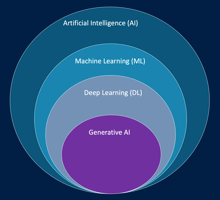

L’intelligence artificielle (IA) désigne un ensemble de technologies et de méthodes visant à créer...

Cycle de vie Machine Learning

Le Cycle de Vie d’un Projet de Machine Learning

Mettre en œuvre un projet de Machine Learning ne consiste pas seulement à entraîner un modèle : c’est un processus global, structuré en plusieurs étapes, qui combine expertise technique, compréhension métier et rigueur méthodologique.

Chaque phase est essentielle pour garantir que le modèle produit des résultats fiables, utiles et exploitables.

1. Comprendre le Problème et Définir les Objectifs

Tout projet commence par une phase de compréhension du besoin. Avant même de parler de modèles ou d’algorithmes, il faut savoir quel problème concret l’organisation cherche à résoudre.

Cela suppose de travailler avec les équipes métiers pour :

-

Identifier la valeur attendue du projet (par exemple : anticiper la demande de production, automatiser la classification de documents, améliorer la détection de défauts dans une chaîne industrielle) ;

-

Déterminer les indicateurs de performance qui permettront de juger du succès du modèle ;

-

Évaluer la pertinence du machine learning comme solution. Parfois, un algorithme classique ou une simple règle métier peut suffire.

À la fin de cette étape, le problème métier est reformulé en un problème d’apprentissage automatique (par exemple : prédire une valeur → régression ; classer des catégories → classification ; regrouper des comportements → clustering).

2. Collecte et Préparation des Données

Une fois la problématique définie, le projet entre dans sa phase la plus exigeante : la collecte et la préparation des données.

Les données peuvent provenir de multiples sources — bases de données internes, fichiers journaux, capteurs IoT, images, formulaires en ligne, ou données publiques.

Le défi n’est pas seulement d’obtenir ces données, mais surtout de les rendre propres et exploitables :

-

Suppression des valeurs aberrantes et des doublons ;

-

Traitement des valeurs manquantes ;

-

Conversion et harmonisation des formats (par exemple, transformer des dates, des devises ou des unités).

Cette étape inclut souvent une analyse exploratoire des données (Exploratory Data Analysis ou EDA) : on observe les distributions, on identifie les corrélations et on détecte les biais potentiels.

Par exemple, dans un projet de prévision du trafic routier, on peut visualiser la relation entre les conditions météorologiques, l’heure de la journée et le nombre de véhicules enregistrés.

3. Ingénierie des Caractéristiques (Feature Engineering)

Les données brutes ne sont pas toujours prêtes à être utilisées telles quelles.

L’ingénierie des caractéristiques consiste à créer de nouvelles variables plus pertinentes à partir des données existantes afin de faciliter l’apprentissage du modèle.

Par exemple :

-

Dans un projet d’analyse de churn (perte de clients), on peut dériver des variables comme la durée moyenne d’abonnement, le délai depuis la dernière interaction ou la fréquence d’utilisation d’un service.

-

Dans un modèle de détection de panne, on peut combiner plusieurs mesures de capteurs en un seul indicateur de stabilité.

Cette étape demande à la fois de la créativité et une bonne compréhension du domaine métier.

Un bon feature engineering peut souvent avoir plus d’impact sur les performances du modèle que le choix de l’algorithme lui-même.

4. Entraînement du Modèle

Une fois les données prêtes, vient la phase d’apprentissage.

Le modèle est exposé aux données d’entraînement pour identifier des motifs et des relations entre les variables.

Selon la nature du problème, on peut utiliser différents types d’algorithmes :

-

Régression linéaire ou logistique pour des tâches simples ;

-

Arbres de décision ou forêts aléatoires pour des relations plus complexes ;

-

Réseaux de neurones profonds pour des données riches comme les images ou le texte.

L’entraînement consiste à ajuster les paramètres du modèle pour minimiser une fonction de perte, c’est-à-dire l’écart entre les prédictions et les résultats attendus.

Durant cette phase, les hyper-paramètres — tels que le taux d’apprentissage, la taille du lot ou la régularisation — influencent la vitesse et la qualité de la convergence.

Il faut souvent expérimenter plusieurs combinaisons pour trouver le meilleur équilibre entre performance et stabilité.

5. Évaluation du Modèle

Une fois le modèle entraîné, il doit être évalué sur un jeu de test indépendant pour mesurer sa capacité à généraliser à de nouvelles données.

Les métriques de performance dépendent du type de tâche :

-

Pour la classification : précision, rappel, F1-score, courbe ROC-AUC ;

-

Pour la régression : erreur moyenne absolue (MAE), erreur quadratique moyenne (RMSE) ;

-

Pour les modèles génératifs : ROUGE, BLEU ou BERTScore, qui comparent les textes générés à des références humaines.

Cette évaluation permet d’éviter deux pièges courants :

-

Le sous-apprentissage, lorsque le modèle est trop simple pour capturer les relations réelles ;

-

Le sur-apprentissage, lorsqu’il mémorise trop précisément les exemples d’entraînement et perd sa capacité à généraliser.

Si les résultats ne sont pas satisfaisants, il faut souvent revenir en arrière : améliorer la qualité des données, ajuster les hyperparamètres, ou essayer un autre algorithme.

6. Déploiement en Production

Quand le modèle atteint le niveau de performance attendu, il peut être intégré dans un environnement réel pour effectuer des prédictions.

Le déploiement peut prendre plusieurs formes :

-

En temps réel (ex. : un assistant vocal qui répond instantanément à une requête) ;

-

En mode batch (ex. : un modèle qui analyse chaque nuit des milliers de transactions bancaires) ;

-

En mode sans serveur (serverless), pour les cas où la charge varie fortement.

Le déploiement ne se limite pas à une question technique. Il implique aussi :

-

La gestion des versions de modèles ;

-

Le suivi de la latence et de la disponibilité ;

-

La sécurité des données et la conformité réglementaire.

7. Suivi et Ré-entraînement du Modèle

Une fois en production, un modèle n’est jamais “fini”.

Les données évoluent, les comportements changent, et les conditions du monde réel peuvent rapidement rendre les prédictions moins fiables.

C’est pourquoi une surveillance continue est indispensable.

Cette surveillance consiste à :

-

Détecter les dérives de données (changement dans la distribution des entrées) ;

-

Repérer les dérives de concept (les relations entre les variables changent dans le temps) ;

-

Mesurer les performances sur les nouvelles données réelles.

Lorsque le modèle commence à se dégrader, il faut planifier un réentraînement à partir des données les plus récentes.

Ce cycle d’amélioration continue permet de garder le modèle pertinent, robuste et aligné sur les objectifs métier.

Conclusion

Le cycle de vie du Machine Learning est un processus dynamique et collaboratif.

Il s’appuie sur une compréhension fine du problème métier, une préparation rigoureuse des données et une vigilance continue après le déploiement.

--

Ce billet de blog fait partie du cours AWS AI Practitioner en français disponible sur Udemy et sur la plateforme LeCloudFacile.com.