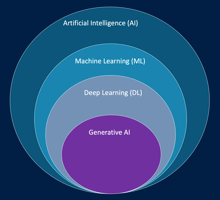

L’intelligence artificielle (IA) désigne un ensemble de technologies et de méthodes visant à créer...

Evaluation des LLMs

Evaluation des modèles de langage (LLMs)

L’évaluation des modèles de langage est cruciale pour mesurer la qualité, la précision et la pertinence des réponses générées. Cela permet d’identifier les points forts, les limites et les biais potentiels d’un modèle.

Méthodes d’évaluation

1. Évaluation automatique

L’évaluation automatique consiste à mesurer la qualité d’un modèle de manière systématique et reproductible, souvent à l’aide d’un jeu de données de référence et d’un modèle juge.

Processus :

-

Définir un type de tâche : résumé de texte, questions-réponses, classification, génération ouverte, etc.

-

Fournir un jeu de données d’invite (intégré ou personnalisé).

-

Définir des réponses de référence, c’est-à-dire la sortie idéale pour chaque invite.

-

Soumettre les invites au modèle à évaluer, qui génère ses réponses.

-

Comparer les réponses générées aux réponses de référence, soit via un modèle juge automatique, soit via une évaluation humaine.

Exemple pratique :

Pour un modèle génératif destiné à produire des descriptions touristiques :

-

Invite : « Décris le parc national de Yellowstone. »

-

Réponse de référence : « Le parc national de Yellowstone offre des geysers spectaculaires, des sources chaudes et une faune abondante. »

-

Réponse générée : « Yellowstone est célèbre pour ses geysers et sa diversité animale impressionnante. »

L’évaluation automatique mesure à quel point le modèle respecte le contenu et la formulation souhaités.

2. Évaluation humaine

L’évaluation humaine consiste à faire juger les réponses par des experts ou des employés :

-

Les évaluateurs comparent les réponses générées aux réponses de référence.

-

Ils peuvent utiliser des mesures qualitatives : pouces en l’air / en bas, classement de 1 à 5, notes sur la pertinence ou la clarté.

Exemple pratique :

Pour un modèle d’assistant juridique :

-

Invite : « Quels sont les points clés du contrat de location commerciale ? »

-

L’évaluateur humain note la précision et la complétude de la réponse, et peut donner un feedback pour améliorer le modèle.

Métriques principales d’évaluation

1. ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

ROUGE mesure la similitude entre le texte généré et le texte de référence, en se concentrant sur les n-grammes et les séquences de mots :

-

ROUGE-N : évalue combien de séquences de N mots du texte de référence apparaissent dans le texte généré (N = 1, 2, 3…).

-

ROUGE-L : mesure la plus longue sous-séquence commune entre le texte de référence et le texte généré.

Exemple pratique :

Texte de référence : « Le nouveau musée présente des expositions interactives et des ateliers pour enfants. »

Texte généré : « Le musée propose des ateliers pour enfants et des expositions interactives. »

ROUGE-L identifie que la séquence de mots commune « des expositions interactives et des ateliers pour enfants » est partiellement respectée, donnant un score élevé.

2. BLEU (Bilingual Evaluation Understudy)

BLEU est utilisé pour évaluer la qualité des traductions ou du texte généré par rapport à une référence :

-

Compare les n-grammes du texte généré avec ceux du texte de référence.

-

Intègre une pénalisation si le texte est trop court (brevity penalty).

-

Utile pour les tâches où l’ordre des mots et la précision lexicale sont importants.

Exemple pratique :

Texte de référence : « The library opens at 8 AM and closes at 8 PM. »

Traduction générée : « La bibliothèque ouvre à 8h et ferme à 20h. »

BLEU mesure la précision lexicale et l’ordre correct des mots.

3. BERTScore

BERTScore utilise des embeddings de type BERT pour mesurer la similarité sémantique entre le texte généré et le texte de référence :

-

Compare le sens global plutôt que la correspondance exacte des mots.

-

Utile pour les textes où différentes formulations peuvent avoir le même sens.

Exemple pratique :

Réponse générée : « Le restaurant propose un menu végétarien varié. »

Réponse de référence : « L’établissement offre plusieurs options végétariennes. »

BERTScore détecte que le sens est similaire même si les mots sont différents.

4. Perplexité

La perplexité mesure la capacité d’un modèle à prédire le prochain mot dans une séquence :

-

Une faible perplexité indique que le modèle est confiant et cohérent.

-

Permet d’évaluer la fluidité et la cohérence globale du texte généré.

Exemple pratique :

Pour un modèle génératif de descriptions de films, une faible perplexité montre que le texte produit suit logiquement la structure de la phrase et respecte la syntaxe attendue.

Points clés à retenir sur les métriques

-

ROUGE : mesure la correspondance des n-grammes pour les résumés ou textes similaires.

-

BLEU : mesure la précision lexicale, principalement pour la traduction.

-

BERTScore : mesure la similarité sémantique pour des reformulations ou variations linguistiques.

-

Perplexité : mesure la cohérence et la confiance du modèle sur le texte généré.

Ces métriques peuvent être combinées pour avoir une évaluation complète du modèle, et permettent de détecter les erreurs, les biais et les limitations tout en guidant l’optimisation.