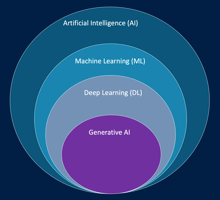

L’intelligence artificielle (IA) désigne un ensemble de technologies et de méthodes visant à créer...

L’ajustement des hyperparamètres (Hyperparameter Tuning)

Dans tout projet d’apprentissage automatique, la performance d’un modèle ne dépend pas uniquement de la qualité des données : elle dépend aussi du réglage précis des hyperparamètres.

Ces paramètres jouent un rôle essentiel dans la façon dont le modèle apprend, converge et généralise ses connaissances.

1. Qu’est-ce qu’un hyperparamètre ?

Un hyperparamètre est une variable qui contrôle le processus d’apprentissage d’un modèle.

Contrairement aux paramètres internes du modèle (comme les poids dans un réseau de neurones, qui sont appris automatiquement pendant l’entraînement), les hyperparamètres sont définis à l’avance par l’ingénieur ou le data scientist.

Ils déterminent :

-

la structure du modèle (par exemple, le nombre de couches ou de neurones dans un réseau de neurones),

-

le comportement de l’algorithme d’entraînement (par exemple, la vitesse d’apprentissage, la régularisation, le nombre d’itérations, etc.).

Un bon réglage de ces hyperparamètres est crucial pour obtenir un modèle performant, stable et capable de bien généraliser sur de nouvelles données.

2. Exemples d' hyperparamètres à connaître

a) Le taux d’apprentissage (Learning Rate)

Il contrôle la vitesse à laquelle le modèle ajuste ses poids à chaque itération.

-

Si le taux est trop élevé, le modèle risque de sauter la solution optimale et de devenir instable.

-

S’il est trop faible, le modèle apprend très lentement et peut se bloquer dans un résultat imparfait.

L’objectif est de trouver un équilibre entre rapidité et stabilité de convergence.

b) La taille du lot (Batch Size)

Elle représente le nombre d’exemples utilisés pour mettre à jour les poids du modèle lors d’une itération.

-

Un petit lot rend l’apprentissage plus stable et précis, mais plus lent.

-

Un grand lot accélère le calcul, mais peut conduire à une convergence moins fine ou plus bruitée.

Le choix dépend donc du compromis entre performance et ressources disponibles.

c) Le nombre d’époques (Epochs)

Une époque correspond à un passage complet sur l’ensemble des données d’entraînement.

-

Trop peu d’époques : le modèle n’a pas eu le temps d’apprendre (sous-apprentissage).

-

Trop d’époques : le modèle finit par “mémoriser” les données et perd sa capacité de généralisation (surapprentissage).

Le but est de s’arrêter au moment où le modèle cesse de s’améliorer sur les données de validation.

d) La régularisation (Regularization)

Elle permet de contrôler la complexité du modèle pour éviter qu’il ne s’adapte trop précisément aux données d’entraînement.

Augmenter la régularisation revient à pénaliser les modèles trop complexes, ce qui favorise la généralisation.

Les techniques courantes incluent L1, L2 ou Dropout (dans les réseaux de neurones).

3. Pourquoi ajuster les hyperparamètres ?

L’objectif du réglage des hyperparamètres est d’optimiser les performances du modèle.

En ajustant ces paramètres, on cherche à :

-

Améliorer la précision et la robustesse du modèle,

-

Réduire le surapprentissage (overfitting),

-

Améliorer la généralisation aux nouvelles données,

-

Trouver un compromis optimal entre temps d’entraînement et qualité du résultat.

C’est un processus itératif, souvent automatisé, qui nécessite à la fois expérience et expérimentation.

4. Les méthodes d’ajustement des hyperparamètres

Il existe plusieurs stratégies pour trouver la meilleure combinaison d’hyperparamètres :

-

Recherche par grille (Grid Search) : on définit plusieurs valeurs possibles pour chaque hyperparamètre et on teste toutes les combinaisons possibles.

→ Méthode exhaustive mais coûteuse en calcul. -

Recherche aléatoire (Random Search) : on explore aléatoirement différentes combinaisons.

→ Moins exhaustive mais souvent plus efficace pour des modèles complexes. -

Optimisation bayésienne ou services automatiques : des outils comme Amazon SageMaker Automatic Model Tuning (AMT) utilisent des algorithmes intelligents pour ajuster automatiquement les hyperparamètres et converger vers les meilleures valeurs possibles.

→ Gain de temps considérable et réduction des essais manuels.

5. Comprendre et éviter le surajustement (Overfitting)

Le surajustement survient lorsque le modèle apprend trop bien les détails ou le “bruit” des données d’entraînement, au point de perdre sa capacité à généraliser.

Il performe très bien sur les données connues, mais échoue sur les nouvelles.

Les causes les plus fréquentes :

-

Un modèle trop complexe,

-

Un trop grand nombre d’époques,

-

Un jeu de données trop petit ou non représentatif,

-

Une absence de régularisation.

Les solutions :

-

Augmenter la taille et la diversité du jeu de données,

-

Appliquer une régularisation adaptée,

-

Arrêter l’entraînement au bon moment (technique de early stopping),

-

Utiliser la validation croisée pour évaluer la robustesse du modèle,

-

Ajuster finement les hyperparamètres (taux d’apprentissage, nombre d’époques, taille du lot, etc.).

6. Exemple illustratif

Imaginons que vous entraîniez un modèle pour prédire la demande en énergie d’une ville.

Au départ, votre modèle apprend trop vite (taux d’apprentissage trop élevé) et produit des prédictions incohérentes.

Après avoir réduit ce taux, le modèle devient plus stable, mais met beaucoup plus de temps à converger.

Vous ajustez alors la taille du lot et le nombre d’époques pour trouver le bon équilibre.

Enfin, vous ajoutez une régularisation légère pour éviter que le modèle ne s’adapte trop aux fluctuations passagères de vos données.

Ce processus illustre bien la nature expérimentale du réglage d’hyperparamètres : il s’agit d’un travail d’ajustement progressif, guidé par l’analyse des résultats.

7. En résumé

L’ajustement des hyperparamètres est une étape essentielle de la conception d’un modèle d’apprentissage automatique performant.

Il demande de la rigueur, de l’expérimentation et une bonne compréhension des interactions entre les paramètres.

Un bon data scientist ou ingénieur en machine learning sait que :

-

Il n’existe pas une seule bonne valeur d’hyperparamètre,

-

Mais une combinaison optimale adaptée aux données et à l’objectif.

Grâce à des outils modernes d’automatisation comme SageMaker AMT, cette étape devient plus accessible, mais la compréhension du principe reste indispensable pour interpréter correctement les résultats et améliorer les modèles.