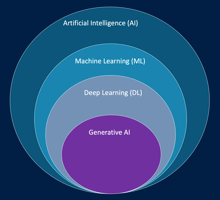

L’intelligence artificielle (IA) désigne un ensemble de technologies et de méthodes visant à créer...

Prompt Engineering

Introduction

Le Prompt Engineering est l’art de concevoir, structurer et optimiser les instructions que l’on fournit à un modèle de langage (LLM) pour obtenir des résultats précis et pertinents. Contrairement à une question simple ou vague, un prompt bien conçu permet de guider le modèle et de réduire les interprétations indésirables, garantissant ainsi des réponses plus fiables et adaptées au contexte.

1. Structure d’un prompt efficace

Pour obtenir une réponse pertinente d’un LLM, un prompt complet doit comporter quatre éléments principaux :

Instructions

Les instructions définissent la tâche que le modèle doit accomplir. Elles décrivent clairement le type de réponse attendu et la manière dont elle doit être formulée. Par exemple, au lieu de demander simplement "Expliquez ce qu’est le Big Data", on peut préciser : "Rédigez un résumé concis de 3 phrases expliquant le Big Data à un public non technique."

Contexte

Le contexte fournit des informations externes pour aider le modèle à adapter sa réponse. Il peut inclure le niveau de connaissance attendu de l’utilisateur ou des détails spécifiques sur la situation. Par exemple, si le public est composé de jeunes étudiants, le prompt peut préciser que la réponse doit rester simple et illustrative.

Données d’entrée

Ce sont les informations spécifiques sur lesquelles le modèle doit se baser pour produire sa réponse. Par exemple, fournir un article ou un extrait de texte à résumer ou à analyser permet au modèle de se concentrer sur ce contenu précis plutôt que de générer une réponse générale.

Indicateur de sortie

L’indicateur de sortie définit le format ou le type de réponse attendu. Il peut s’agir d’un nombre de phrases, d’un style d’écriture, d’un format de tableau ou d’une structure spécifique. Cette précision réduit l’ambiguïté et augmente la qualité de la réponse.

2. Techniques avancées de Prompt Engineering

Prompt négatif

Le prompt négatif consiste à indiquer explicitement ce que le modèle ne doit pas inclure dans sa réponse. Cette technique permet d’éviter les informations non pertinentes ou inappropriées. Par exemple, pour un résumé d’article sur l’intelligence artificielle, on peut demander au modèle : "Évitez les détails techniques et les exemples de code."

Zero-shot et Few-shot

-

Zero-shot : le modèle reçoit une tâche sans aucun exemple préalable. Il s’appuie uniquement sur ses connaissances générales pour générer une réponse.

-

Few-shot : le modèle reçoit quelques exemples illustratifs pour guider sa réponse. Par exemple, pour générer un résumé de produit, on peut fournir deux exemples de résumés avant de demander un nouveau résumé.

Chaîne de pensée (Chain-of-Thought)

Cette approche consiste à demander au modèle de résoudre une tâche en plusieurs étapes logiques. Par exemple, pour générer un plan de projet, on peut instruire le modèle : "D’abord identifiez les objectifs, ensuite listez les étapes principales, puis proposez un calendrier."

Génération augmentée par récupération (RAG)

Le RAG combine les capacités du modèle avec des données externes pertinentes. Par exemple, pour écrire un rapport sur l’écologie urbaine, le modèle peut récupérer des informations récentes sur la biodiversité locale et les intégrer dans le texte final. Cette approche enrichit le prompt et améliore la pertinence de la réponse.

3. Paramètres influençant la génération

Pour optimiser les réponses d’un LLM, certains paramètres peuvent être ajustés :

-

Température : contrôle la créativité de la réponse. Une valeur faible (0,2) produit des réponses conservatrices et cohérentes, tandis qu’une valeur élevée (1,0) génère des réponses plus variées et créatives.

-

Top P (nucleus sampling) : limite la sélection aux mots représentant un certain pourcentage de probabilité cumulative. Une valeur basse produit des réponses plus prévisibles, une valeur élevée favorise la diversité.

-

Top K : limite le choix du modèle aux K mots les plus probables. Cela influence la cohérence et la diversité de la sortie.

-

Longueur maximale : définit combien de mots ou tokens le modèle peut générer.

-

Séquences d’arrêt : spécifie des jetons indiquant au modèle de terminer sa génération.

4. Performance et latence

La vitesse de réponse d’un LLM, ou latence, dépend de plusieurs facteurs : la taille du modèle, le type de modèle, la quantité de texte fourni en entrée et la longueur de la réponse demandée. Les paramètres comme la température ou le Top P n’influencent pas directement la latence. Comprendre ces contraintes est important pour concevoir des prompts efficaces et rapides, surtout dans un contexte d’utilisation en production.

Conclusion

Le Prompt Engineering est une compétence clé pour exploiter pleinement les modèles de langage. En structurant soigneusement les prompts, en utilisant des techniques avancées comme le prompt négatif, le few-shot, la chaîne de pensée ou le RAG, et en ajustant les paramètres de génération, on peut obtenir des réponses précises, pertinentes et adaptées au contexte. La maîtrise de cette pratique permet d’améliorer la qualité des interactions avec les LLM et de maximiser leur utilité dans des applications réelles.

--

Ce billet de blog fait partie du cours AWS AI Practitioner en français disponible sur Udemy et sur la plateforme LeCloudFacile.com.