1. Introduction L’apprentissage supervisé est l’une des approches les plus fondamentales et les...

L’apprentissage auto-supervisé (Self-Supervised learning)

L’apprentissage auto-supervisé

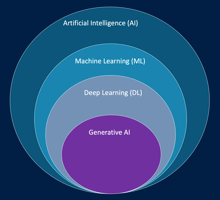

L’apprentissage auto-supervisé est une approche d’intelligence artificielle située à mi-chemin entre l’apprentissage supervisé et l’apprentissage non supervisé.

Dans ce type d’apprentissage, le modèle dispose d’un grand volume de données non étiquetées (aucune réponse correcte fournie par un humain). Cependant, au lieu de rester totalement livré à lui-même, il va générer ses propres étiquettes à partir des données disponibles.

Autrement dit, les données deviennent leur propre source d’enseignement.

Le modèle apprend d’abord à résoudre de petites tâches créées automatiquement (appelées tâches prétextes) qui l’aident à comprendre la structure et les relations internes des données.

Une fois cette étape franchie, il peut être réutilisé pour des tâches plus complexes, comme la classification, la traduction, la reconnaissance d’images ou la synthèse de texte.

Pourquoi l’apprentissage auto-supervisé ?

L’annotation manuelle des données est souvent longue, coûteuse et sujette à l’erreur humaine.

Dans de nombreux domaines, comme la vision par ordinateur, le traitement du langage naturel ou la reconnaissance vocale, il existe d’énormes quantités de données non étiquetées.

L’apprentissage auto-supervisé permet donc de tirer parti de ces données brutes en créant automatiquement des étiquettes artificielles.

C’est une façon de préparer le modèle à comprendre le monde, sans supervision humaine directe.

Exemple 1 : apprentissage sur des vidéos

Imaginons que nous disposions de milliers d’heures de vidéos, mais sans aucune annotation sur ce qu’elles contiennent.

Nous pouvons créer une tâche prétexte consistant à prédire la prochaine image d’une séquence à partir des images précédentes.

Le modèle apprend alors à reconnaître les dynamiques visuelles : le mouvement des objets, la continuité des scènes, ou encore les changements d’éclairage.

Sans qu’on lui dise explicitement ce qu’est une voiture ou une personne, il apprend peu à peu à comprendre la logique des images dans le temps.

Une fois ce modèle entraîné, il peut être affiné (fine-tuning) sur une tâche précise, comme :

-

Détecter les piétons sur une vidéo de circulation,

-

Identifier les gestes d’un sportif,

-

Ou même résumer automatiquement une séquence vidéo.

Exemple 2 : apprentissage sur des données audio

Prenons maintenant des enregistrements sonores de conversations dans différentes langues.

Sans transcription, on pourrait demander au modèle de reconnaître la partie manquante d’un enregistrement audio : par exemple, prédire les sons manquants dans une phrase tronquée.

En répétant cette tâche sur des millions d’exemples, le modèle apprend à distinguer les rythmes, intonations et structures phonétiques des langues.

Lorsqu’on le réutilise pour une tâche en aval (comme la reconnaissance vocale), il part déjà avec une compréhension approfondie du langage parlé.

Comment cela fonctionne-t-il ?

L’apprentissage auto-supervisé repose sur deux étapes principales :

-

Tâche prétexte (pré-entraînement)

Le modèle apprend à prédire des éléments manquants ou à reconstituer une partie des données à partir du reste.

Exemple :-

Prédire la prochaine image d’une vidéo,

-

Deviner le mot masqué dans une phrase,

-

Compléter une partie manquante d’un son.

-

-

Tâche en aval (fine-tuning)

Une fois le modèle pré-entraîné, il peut être adapté à des tâches spécifiques à l’aide d’un petit jeu de données étiquetées.

Exemple :-

Identifier des émotions dans la voix,

-

Classer des images médicales,

-

Résumer automatiquement des articles.

-

Cette approche permet de réduire la dépendance à l’étiquetage manuel tout en obtenant des performances souvent comparables, voire supérieures, à celles de l’apprentissage supervisé classique.

Exemples concrets dans l’industrie

-

Reconnaissance d’images médicales :

Un modèle peut apprendre à reconstituer les zones manquantes d’une radiographie, puis être utilisé pour détecter des anomalies pulmonaires ou des fractures. -

Systèmes de recommandation :

En prédisant les articles ou vidéos que l’utilisateur consultera ensuite, le modèle apprend à comprendre les préférences sans qu’on lui fournisse d’étiquettes explicites. -

Grands modèles de langage (LLM) :

Des modèles comme GPT, BERT ou LLaMA utilisent des tâches prétextes telles que prédire le mot manquant ou le mot suivant.

Grâce à cet apprentissage auto-supervisé, ils acquièrent une compréhension profonde du langage avant d’être spécialisés sur des tâches comme la traduction, la rédaction ou le dialogue.